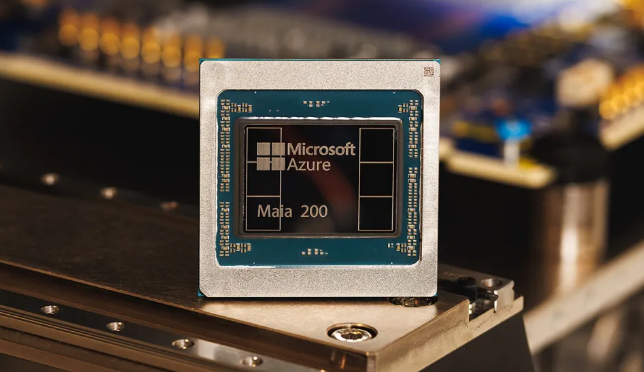

据国外科技媒体消息,微软日期正式发布其第二代自研人工智能加速芯片Maia 200,标志着公司在构建自主AI基础设施方面迈出关键一步。该芯片基于台积电3纳米工艺打造,目前已在位于美国爱荷华州的数据中心投入初期部署,并计划于2026年上半年扩展至亚利桑那州凤凰城区域。

据微软云与人工智能业务执行副总裁斯科特·格思里(Scott Guthrie)介绍,Maia 200被定位为“微软有史以来部署的最高效推理系统”,在单位成本性能上较现有最新硬件提升30%。这一进展被视为微软降低对英伟达GPU依赖、强化算力供应链安全的核心举措。

技术参数方面,Maia 200单芯片集成超1400亿个晶体管,配备216GB HBM3e高带宽内存,内存带宽高达7TB/s。在计算性能上,其FP4精度算力突破10 petaFLOPS,FP8精度超过5 petaFLOPS,整机功耗控制在750瓦以内。相较之下,其FP4性能达到亚马逊第三代Trainium芯片的3倍,FP8性能亦优于谷歌第七代TPU v7,同时在片上内存容量上领先两大竞品。

架构设计上,Maia 200采用基于标准以太网的双层可扩展网络拓扑,支持最多6144颗加速器组成的超大规模集群,无需依赖英伟达主导的InfiniBand互联方案。这一选择不仅降低了组网成本,也增强了与现有Azure数据中心基础设施的兼容性。

应用场景方面,Maia 200将优先服务于微软内部的“超级智能团队”(Superintelligence Team),用于合成数据生成、强化学习训练及下一代大模型优化。同时,该芯片将为Microsoft 365 Copilot、Microsoft Foundry平台及OpenAI最新模型(包括GPT-5.2)提供底层算力支撑。

目前,微软已向部分高校、研究机构及前沿AI实验室开放Maia 200软件开发工具包(SDK)预览版,并计划在未来通过Azure云平台向企业客户开放按需租用服务。尽管微软在自研AI芯片领域起步晚于亚马逊(Trainium)和谷歌(TPU),但Maia 200的推出凸显其从“云服务商”向“全栈AI基础设施提供商”的战略转型。