一场成功的CPU发布会应该是怎样的?大家可能会说,规格拉满,性能至上,没有比这个更关键的了。不过反观英特尔过去数代至强处理器的发布会,就会发现一个特别之处,即:它是会谈新产品增加了多少核心、频率如何变化,内存或互连技术的带宽与频率如何演变,甚至又增添了哪些算力上的加速器或扩展指令集,但始终会留出足够的时间,去详解至强在机密计算或机密AI上的新进展,例如曾经的SGX、TDX,还有去年刚随至强® 6性能核处理器一同亮相的TDX Connect技术。

是什么原因,让英特尔如此执着于可信或机密计算技术在CPU中的演进与强化?这是因为,在大模型崛起的时代,喂给AI应用的海量数据,都是经过重重筛选、精炼,也容纳了最宝贵信息的核心数据,无论它涉及的是企业的关键私有数据、还是个人用户的隐私信息,它们与大模型开发者及应用者正在着手优化或部署的模型的重要参数一样,都是这个智算时代的“核心资产”。

这种情形乃至刷新了AI的三要素理论,即在算力、模型和数据之外,新添了一个安全的要素,而且其边界是把另外三要素完全囊括在内的。

AI对于安全的强需求,让越来越多的客户意识到:他们的AI需要可信、可控的端到端部署环境,一个无法被信任的计算环境,就像建立在流沙之上的大厦。只强调性能要素,如算力和存力,最终很可能是“给别人做了嫁衣裳”。

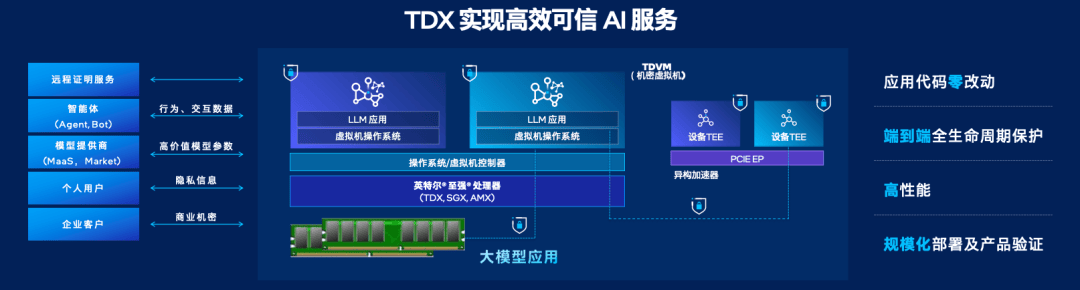

这就要回到英特尔不断强调的基于硬件、集成在CPU里的可信计算或可信AI技术了。它的TDX(Trust Domain Extensions)技术,核心使命就一个:让CPU担起安全控场的角色,让GPU专心做计算,两者结合实现互补,成就既高效又更为可信的AI能力。

简言之,就是“不能为AI模型与数据保驾护航的CPU,不是合格的机头或主控CPU”。让我们来看看这位“安全控场专家”TDX是如何工作的:

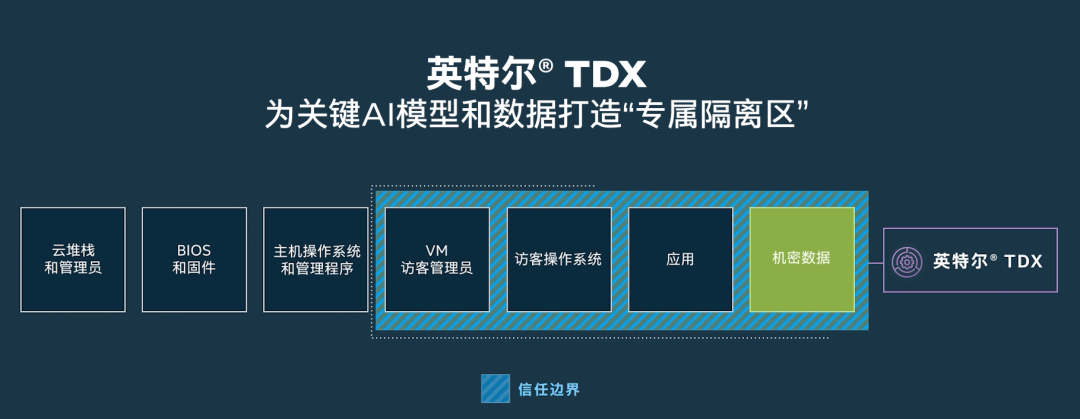

第一招:建“硬件隔离墙”,

打造应用与数据的“保险箱”

TDX技术在服务器运行环境里直接划出一个个“专属隔离区”:TD,即Trust Domain或可信域。你可以把整个虚拟机都放进去。无论是云服务商的管理员,还是想搞小动作的“邻居”租户,哪怕拿到最高系统权限,对这个“专属隔离区”里的模型、应用代码及数据也只能干瞪眼,从物理根源上更好地防止了窥探和篡改。

第二招:给“内存数据”

穿上防弹衣,运行全程加密

数据在计算时,总要在内存里走一遭,这是传统的数据防护技术最薄弱,甚至可以说是“裸奔”的环节。TDX通过结合英特尔® TME-MK技术,实现了对可信域内存数据的实时、全程加密。

第三招:入门先

“验明正身”,防止“无间道”

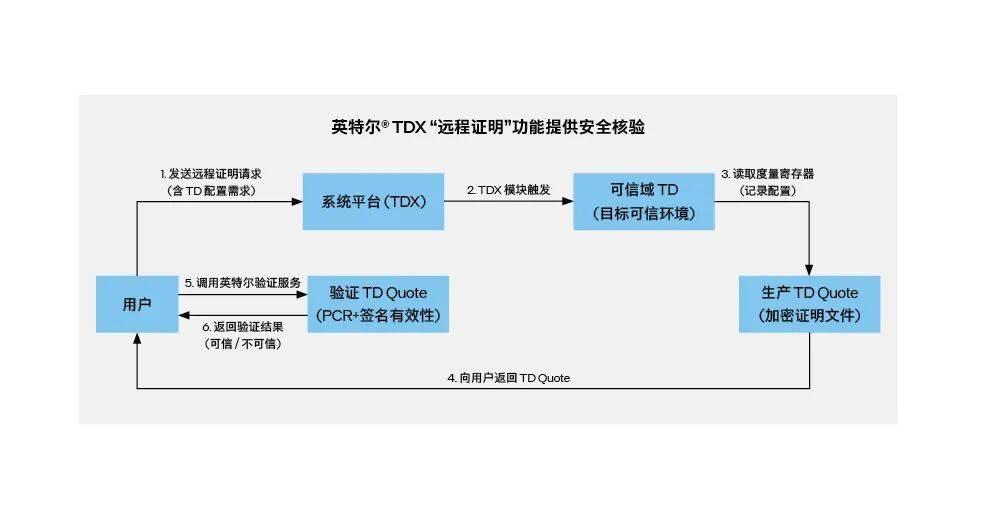

信任不能仅凭承诺,更需要可验证的机制。TDX的“远程证明”功能,允许用户在将敏感数据或模型部署到云端环境之前,确认了云端环境是原装正品、未经篡改才会继续工作。想玩“无间道”,门儿都没有。

第四招:为CPU与GPU建加密“专线”

CPU的安全控场功能,可不是自娱自乐,而是要拉GPU一起——当CPU要和GPU协同处理AI任务时,TDX Connect技术可在CPU可信域和GPU等异构加速器之间,建立一条硬件加密的数据通道,让“CPU+GPU”这对黄金搭档的协同既快,又更保险。

光说不练假把式,大厂早已用得飞起

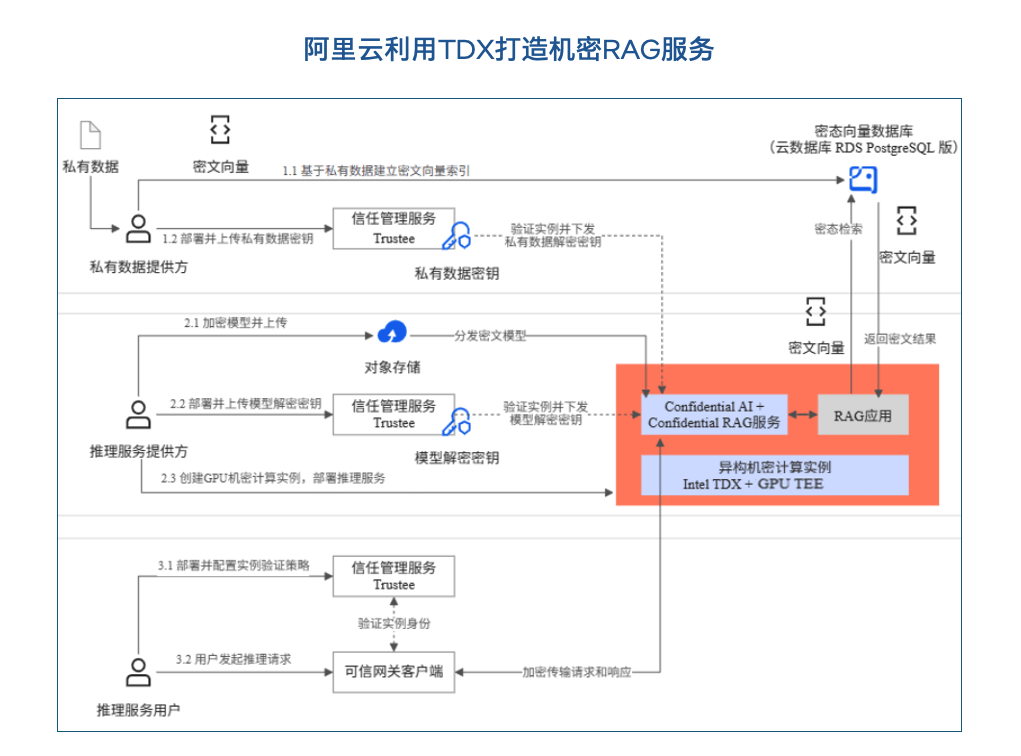

这套“至强CPU + TDX护航”的组合拳,早已不是PPT上谈兵,而是在各大云厂商的AI服务中落地开花。例如阿里云的机密RAG服务就利用TDX将向量数据库和检索服务整个“打包”进硬件保险箱,数据安全和运行效率两者兼得。

又如火山引擎 Jeddak AICC 基于TDX,为各类智能应用量身打造的端云一体 AI 可信基座,能在筑牢数据与模型安全壁垒的同时兼顾运行性能,真正实现 “安全不打折、性能不缩水”。

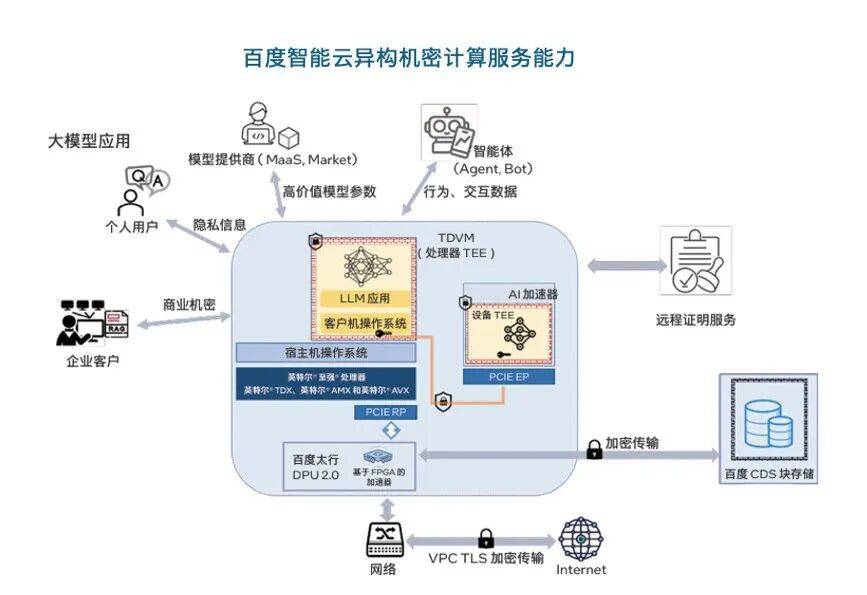

而百度智能云也基于TDX,打造了弹性高可用的异构机密计算实例,为客户在云上更高效安全地运行大模型工作负载,提供了更多选择和灵活性。

可见,如今要评价AI服务器或集群的机头或主控CPU是否优秀,不仅要看它算力和存力上能否与GPU配合默契,协作高效,还要考量它能否借助TDX这样的安全技术,成为整个AI端到端工作流程中那个最值得信赖的“守护者”。而这,正是至强® 6处理器作为AI机头CPU的一大核心价值,而且就其技术成熟度和用户接受度而言,这种价值也算得上是“傲视群雄”了。

想解锁借助至强® 6与TDX实现可信AI的秘籍?

请访问英特尔官网,解锁更多TDX潜能。