快手展示多模态超大模型在短视频场景落地应用等多项新技术方案

日前,在NVIDIA GTC 2023大会上,多位来自快手的技术专家,展示了一系列前沿技术及解决方案:涵盖了从视频画质提升、数字人直播及互动解决方案,到定制性能优化新框架、针对大型推荐模型的性能优化,以及多模态超大模型在短视频场景落地等多个话题。

画质提升秘籍 视频画质评估算法和画质修复增强方案

快手App每天都要产生数千万条新增UGC短视频内容。用户发布一条视频,只需要几秒钟,增加一些特效,也只需要简单几个步骤。但鲜为人知的是,为了提供更加清晰的画质,每条短视频在触达用户前都经历了重重“关卡”,这背后是快手技术团队持续的工程、算法技术积累。

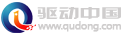

快手音视频图像算法负责人孙明在《快手视频质量评价和画质增强解决方案》演讲中提到,在一条短视频从生产到消费的整体链路上,与画质相关的主要有拍摄、编辑和服务端处理这三个阶段。同时在下发到移动端的过程中,视频画质仍受制于网络环境、带宽成本、用户端机型等因素影响。

为解决这个问题,快手针对UGC视频特性提出了视频画质评估算法体系(KVQ)和画质修复增强方案(KRP/KEP)。两者相辅相成,大幅提升了消费侧画质清晰度。

如何在有限的算力下尽可能把算法效果发挥到极致,实现降本增效?快手视频质量评价框架使用了AI方法来驱动算法开发。“早期我们建立了大量的内部测试集,发现哪怕在数据较小的情况下,AI算法仍然比市面上的工具好用,所以后面的迭代主要围绕在内容多样性、处理多样性、codec多样性三个问题来解决。”孙明表示。

快手画质修复“秘籍”

现如今KVQ已广泛应用于快手内部多个业务场景中,如全链路质量监控、基于内容的自适应处理和编码、搜索推荐等。同时,在StreamLake业务中,KVQ已经实现商业化,并为业内数家知名公司提供服务。

数字人直播及互动解决方案 助力游戏营销

最近几年,前沿技术的革新也逐渐带动了虚拟技术的升级。快手视觉互动技术负责人简伟华分享的《快手 3D 数字人直播及互动解决方案》,介绍了快手围绕3D数字人,基于快手虚拟世界互动平台KMIP和快手虚拟演播助手KVS,在直播、社交等领域进行的系列实践。

以游戏场景为例,数字人主播使用快手虚拟演播助手(KVS),以3D形象参与到游戏中,除了自己体验并讲解游戏玩法外,用户也可以在主播的引导下与之进行互动,从而参与游戏进程与结果,甚至可通过打赏等方式入场,以沉浸式第一人称视角操控角色。

在技术的加持下,快手站内参与主题游戏虚拟世界互动的中小主播营收增加了50%以上,直播间付费率提升了2倍以上;带货方面,情人节期间,快手官方联合多位快手虚拟主播进行的直播带货共计4245万人观看,最高同时在线达到3万多人,300万人互动。

快手称,希望以3D数字人的技术栈支持主播和游戏宣发生态,实现多端打通,游戏营销的同时助力直播间个性化互动内容的生产,与平台进行深度联动。用户也可直接参与互动,这样一来,快手既承接了获取流量的部分,也赋予了游戏平台新的互动形式。

快手定制性能优化新框架

在针对更深层次的算法与模型优化方面,快手算法引擎专家门春雷在《基于TensorRT的端到端子图优化框架》的演讲中进行详细阐述,详细介绍了为用户提供更便捷服务的迭代技术。

据了解,NVIDIA TensorRT是一个高性能的SDK,用于优化通用模型的推理性能。快手AI预估系统广泛采用 TensorRT 进行加速计算,然而,工业模型中有一些非通用子图,仍存在优化空间。

门春雷介绍,为了优化这些非通用子图,快手技术团队专门设计了一种利用AI编译器优化子图的端到端框架。具体来说,该框架会自动分析和裁剪ONNX-Graph中存在性能瓶颈的子图,利用AI编译器对其进行优化,并生成代码以填充到TensorRT插件中。这样,基于TensorRT的二次开发,能够进一步提升服务吞吐,节省计算资源。

针对大型推荐模型的性能优化

作为头部短视频平台,快手日活用户达3.6亿,日均时长超129分钟。推荐服务在短视频、广告、电商等多项业务中都发挥着重要作用。

软件架构师梁潇在《针对大型推荐模型的性能优化》的演讲中表示,面对推荐时效性强和模型过于庞大的问题,快手通过平衡 CPU和GPU的工作负载来优化整个系统,所有的工作都在同一台服务器上完成。这样做既非常易于部署,也能同时充分利用CPU和GPU资源。

方案的实现关键是将部分负载转移到GPU上。为了做到这一点,首先要深度优化CPU算法,并且提升模型在GPU上推理的效率,推理所需的时间越少,就意味着有更多的GPU算力可以用来承载从CPU上迁移的算法。此外,技术团队还尝试在GPU端缓存数据,从而减少对DRAM的访问量。

这些优化的动作使GPU利用率从20%左右大幅提高到近90%,吞吐量提高了十倍以上,能够帮助平台在成本可控的情况下,把效果发挥到极致,更好地为用户提供优质服务。

ChatGPT热潮下 加速多模态超大模型在短视频场景落地应用

今年以来,ChatGPT持续火爆,让其背后的多模态大模型技术受到更多关注,也为行业带来了诸多AI大模型技术研究热潮。超大模型和超级算力结合加速了技术的应用,大模型已经从自然语言处理扩展到计算机视觉、多模态领域等。

在《多模态超大模型短视频场景落地应用》这一演讲中,张胜卓、韩青长、李杰三位技术专家介绍,为了解决大模型应用中共性问题,快手开展技术攻关,沉淀了通用的混合并行训练、推理优化和模型部署整套解决方案。该方案已在快手的多个场景落地,以较低的资源成本取得了显著的业务收益。

快手技术团队称,通过研究发现,训练时间漫长、推理效率过低、部署相对复杂是多模态超大模型工程应用的三大拦路虎。为全链路解决上述问题,快手围绕提高模型计算效率和可部署开展技术攻关,沉淀了通用的混合并行训练、推理优化和模型部署整套解决方案。

据悉,目前多模态超大模型已在快手的多个场景落地,以较低的资源成本推动业务开展,探索出了大模型从训练到落地的技术路径。同时,结合快手海量的视频资源和多媒体场景,多模态超大模型可以利用多模态特征构建通用理解能力,应用于推荐、广告、搜索、电商等核心业务。

在ChatGPT和GPT-4带动下,AIGC大火。随着AI技术的进一步发展,大模型以及多模态模型的商业化应用将进一步加速。 十年磨一剑,诸如快手等科技巨头,将凭借多年提炼的技术“秘籍”,持续赋能亿万用户。快手内部文档请勿外传

评论 {{userinfo.comments}}

-

{{child.nickname}}

{{child.create_time}}{{child.content}}

{{question.question}}

提交

活水洗地的工程拐点:从“可用”到“好用”,活水洗地如何完成关键一跃

刘强东为老家宿迁光明村村民送出万件年货

昨夜今晨:国家发改委推进两新补贴全国统一化 石头科技发布多款新品

联想moto X70 Air Pro AI手机正式发布:不止Air,有AI更Pro

驱动号 更多