中国版大数据“哨兵” 观数科技亮相BDTC2016

日前,由中国计算机学会(CCF)主办,CCF大数据专家委员会承办的2016中国大数据技术大会(BDTC2016)在北京新云南皇冠假日酒店隆重举办。北京观数科技有限公司CEO李科作为演讲嘉宾应邀参加了盛会,并分享了观数科技在大数据安全领域的技术与经验。

对于大数据生态安全之前一直都是国外厂商在唱“独角戏”,如Cloudera、Hortonworks等都为Hadoop生态提供了安全解决方案。伴随大数据在国内的迅速发展,观数科技凭借其安全行业丰富经验,在进入该领域后,迅速成为国内首家大数据基础框架安全解决方案提供商。观数科技从事信息安全工作十余年,是新兴的创业公司,目前正在进行Pre-A轮融资。

中国版大数据“哨兵”

一直以来,国内的大数据方案提供商在搭建基础架构的时候,多数采取使用国外Apache开源项目,如:Sentry、Ranger、Knox、Kerberos等。国内在此领域相对处于空白,这些优秀的项目当中却没有一个来自于中国,这让作为信息安全工程师出身的观数科技CEO李科有些不甘。他认为,首先用户的可选择余地很少,并且开源组件解决的基本是解决“点”的问题,很难全面的发挥协同作用,以点盖面的解决问题并不能真正形成有效的方案。于是李科带领自己的团队开发出了一款独立的大数据安全访问控制产品BIG DAF,让国内用户在大数据平台的搭建上多了一个选择。

BDCT2016会务组对产品给予了高度评价,从产品的方案构成和自主独立性来看,产品有着很高的技术门槛与先进性,国内2014年以来才开始进入大数据行业真正的发展期,而经过两年的建设,已经有许多行业领域的应用已经初具规模,而阻碍大数据发展的核心问题之一就是安全。日益严重的电信诈骗、个人隐私泄漏、以及行业数据被窃取,正在逼迫我国在该领域立法,制定相关的产业标准。而对这一标准的落地,观数科技的BIG DAF率先走出了一步,在大数据安全这一空白领域,推出了真正自主来源的安全产品。

大数据安全的必要性

1、防的不是外网、内网,防的是风险

企业对于安全防护一般都重外网、轻内网,据IDC统计,企业受到外网攻击风险比例远高于内网,占比高达80%,但造成的损失却低于占比20%的内网,不管是“网震”还是“火焰”,病毒都是属于内网攻击,由于“邮件门”错失总统宝座的希拉里,也要“归功”于内网攻击。所以企业防护重要性不应分内、外网,应该根据企业实际业务风险进行安防。

2、护的不是在线、离线,是业务

应用、数据有些是需要实时处理与分析的,它们是动态的,如:日志实时处理。而有些则是静态的,当需要时才会被使用。对于这种在线、离线状况,安全防护不应分状态,防护的应该是业务。

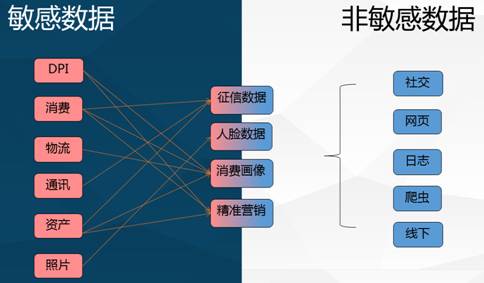

3、保的不是敏感与不敏感,是价值

企业大数据资产不仅产生速度快、容量庞大而且类别繁杂,其中包含许多敏感数据,而企业往往重视敏感数据的保护,忽视了其他数据的价值。但是,大数据价值不仅体现在其原始数据的价值,更体现在分析后的价值,而分析后的价值则是由这些敏感、非敏感数据综合分析出来的,任何一块数据的缺失、破坏都会降低其分析后的价值,因此“完整性”则是非敏感数据的保护要点。

大数据基础框架安全现状

无论是Hadoop、还是Spark生态,在设计之初并未考虑其安全问题,以至于发展至今,他们一直遗留着Linux的安全隐患。每一天都有大量的数据、用户和应用在加入这个日益壮大的集群中来。如何让终端用户在现存的大数据基础架构下,保证数据访问和BI应用程序的充分安全,一直是安全管理员和监察人员挥之不去的困扰。

这些安全问题如:

1、存在root权限过大,可以对资源进行任意修改(Change Permissions、Change Owner);

2、没有安全模型,不对用户或服务进行验证,也没有数据隐私。因此在分布式的设备集群上任何人都能提交代码并执行;

3、MapReduce没有认证或授权的概念,某个顽劣的用户可能为了让自己的任务更快完成而降低其他Hadoop任务的优先级,甚至直接杀掉其他任务;

4、恶意开发人员能轻易假冒其他用户,比如写一个新的TaskTracker并将其注册为Hadoop服务,或者冒充HDFS或MapReduce用户,把HDFS里的东西全删掉等等;

5、DataNode没有访问控制,恶意用户可以绕过访问控制从DataNode中读取任意数据块,或将垃圾数据写到DataNode中破坏目标分析数据的完整性;

对于运营商、金融、政府、医疗保健和其它对敏感数据的访问有严格监管的行业的使用,则提出了更加全面的安全要求:

1、周边安全:确认用户身份,确保集群访问的安全。

2、数据安全:确保集群中的数据不会被非法访问,包括已存储的数据和传输中的数据。

3、访问安全:通过文件系统ACL和细粒度授权,定义授权用户和应用程序对集群数据的权限。

4、可见性:通过审计报告出数据源和数据的用法。

李科介绍, BIG DAF是一款综合权限控制产品,目前已经对HDFS、MapReduce、Yarn、HBase进行了支持,并且还支持内存计算框架Spark。

其原理如下:

DAF控制器是该方案的核心,其作用位置在客户端与大数据服务端之间,DAF控制器能够识别来自各种客户端的OP指令,并起到透明代理的作用,对于OP指令集的研究,除了Hadoop本身的WebHDFS协议以外,还支持流式的RPC协议。

DAF本身有基于OP指令集的ACL,这套ACL有别于Hadoop原生的权限体制,除了读写执行这种基本权限,还增加了更多的权限,并且将用户验证纳入到DAF当中,接管了Hadoop自身的用户列表,因此设置用户可以在安全的环境下进行。

在识别两端的同时,ACL主要包括:角色、用户、数据、指令。有了ACL的控制,DAF控制器就可以准确的识别客户端的指令是否合规。在DAF的基础上实现了访问控制、访问监控、访问审计。

BIG DAF是一款基于大数据基础框架的网关形式访问控制器,可兼容Kerberos。其未修改Hadoop、Spark生态源码,兼容各种原生及商业发行版,实现了大数据的周边安全、数据安全、访问安全、可见性,且BIG DAF为独立体系,无法从Hadoop、Spark生态上配置BIG DAF的安全策略,重要的一点是BIG DAF并不转发流量,ACL与审计只针对主客体访问行为,几乎没有性能消耗。

未来BIG DAF的发展方向将不局限于Hadoop本身,而是定位于大数据组件的安全解决方案,在产品方向上,将围绕常用的大数据生态组件进行支持,李科表示:“观数科技定位是一家高科技企业,我们的优势是在大数据领域的核心技术研究,并非只限于Hadoop”。

目前,BIG DAF是唯一一款通过公安部检测并颁发信息安全专业产品销售许可证的Hadoop安全防护产品,并且已经在一些政府大数据平台进行使用。另外,BIG DAF正积极与国内知名云厂商合作,针对在线大数据平台推出PAAS平台的大数据安全组件。

观数科技的BIG DAF在大数据安全这一空白领域,推出了真正自主来源的安全产品,它也将推动大数据技术在更多行业、组织和终端用户的使用,同时为管理员提供灵活、安全的管理平台。相信随着大数据技术的成熟,未来将有更多的国产品牌加入这个大生态中。

评论 {{userinfo.comments}}

-

{{child.nickname}}

{{child.create_time}}{{child.content}}

{{question.question}}

提交

刘强东为老家宿迁光明村村民送出万件年货

昨夜今晨:国家发改委推进两新补贴全国统一化 石头科技发布多款新品

联想moto X70 Air Pro AI手机正式发布:不止Air,有AI更Pro

董明珠言论被曲解 广汽集团澄清“格力芯片”替代传闻

驱动号 更多